如果服務端要提供文件傳輸的功能,我們能想到的最簡單的方式是:將磁盤上的文件讀取出來,然后通過網絡協議發送給客戶端。

傳統 I/O 的工作方式是,數據讀取和寫入是從用戶空間到內核空間來回復制,而內核空間的數據是通過操作系統層面的 I/O 接口從磁盤讀取或寫入。

代碼通常如下,一般會需要兩個系統調用:

代碼很簡單,雖然就兩行代碼,但是這里面發生了不少的事情。

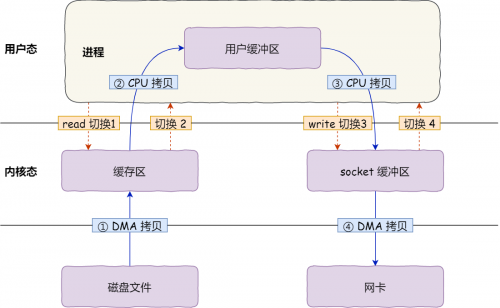

首先,期間共發生了 4 次用戶態與內核態的上下文切換,因為發生了兩次系統調用,一次是 read() ,一次是 write(),每次系統調用都得先從用戶態切換到內核態,等內核完成任務后,再從內核態切換回用戶態。

上下文切換到成本并不小,一次切換需要耗時幾十納秒到幾微秒,雖然時間看上去很短,但是在高并發的場景下,這類時間容易被累積和放大,從而影響系統的性能。

其次,還發生了 4 次數據拷貝,其中兩次是 DMA 的拷貝,另外兩次則是通過 CPU 拷貝的,下面說一下這個過程:

次拷貝,把磁盤上的數據拷貝到操作系統內核的緩沖區里,這個拷貝的過程是通過 DMA 搬運的。 第二次拷貝,把內核緩沖區的數據拷貝到用戶的緩沖區里,于是我們應用程序就可以使用這部分數據了,這個拷貝到過程是由 CPU 完成的。 第三次拷貝,把剛才拷貝到用戶的緩沖區里的數據,再拷貝到內核的 socket 的緩沖區里,這個過程依然還是由 CPU 搬運的。第四次拷貝,把內核的 socket 緩沖區里的數據,拷貝到網卡的緩沖區里,這個過程又是由 DMA 搬運的。

我們回過頭看這個文件傳輸的過程,我們只是搬運一份數據,結果卻搬運了 4 次,過多的數據拷貝無疑會消耗 CPU 資源,大大降低了系統性能。

這種簡單又傳統的文件傳輸方式,存在冗余的上文切換和數據拷貝,在高并發系統里是非常糟糕的,多了很多不必要的開銷,會嚴重影響系統性能。

所以,要想提高文件傳輸的性能,就需要減少「用戶態與內核態的上下文切換」和「內存拷貝」的次數。

京公網安備 11010802030320號

京公網安備 11010802030320號